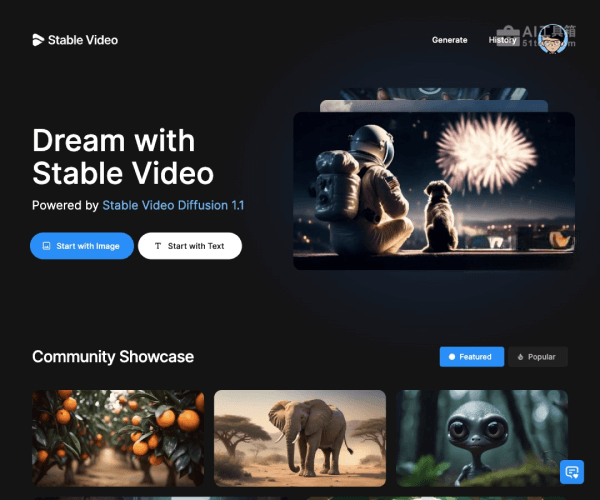

Stable Video Diffusion是什么

Stable Video Diffusion(SVD)是Stability AI于2023年11月发布的视频生成大模型,基于其原有的Stable Diffusion文生图模型开发,支持通过文本或图像生成视频内容。该模型提供14帧和25帧两种版本,支持自定义帧率输出,并具备多视图3D合成能力。

Stable Video Diffusion的主要功能

- 图像到视频生成:上传一张静态图片,模型能自动分析画面内容并生成一段短视频,为图像添加合理的动态效果,例如风吹动树叶、云层流动或简单的物体运动。

- 多视图3D先验:模型能够生成同一对象或场景的多个连贯视角,这为3D建模和新型视图合成任务提供了强大的基础,可以辅助简化3D资产创建流程。

- 可定制的帧率和运动控制:用户可以根据需要调整生成视频的帧率(通常在3至30帧/秒之间),并通过参数(如运动桶ID)对视频中的运动幅度进行一定程度的控制,以适应不同的创作需求。

- 高分辨率输出:模型支持生成1024×576分辨率的高清视频,在纹理细节和画面一致性上表现出色。

Stable Video Diffusion的使用方法

- 在线体验(推荐初学者):可以通过访问Hugging Face或Replicate等平台提供的在线演示页面来体验Stable Video Diffusion。通常只需上传一张图片,选择基本参数(如帧数),即可在线生成并预览视频效果。

- 本地部署(适合开发者):若需要在本地运行,首先需确保计算机配备高性能GPU(建议显存8GB以上)。然后,从GitHub克隆官方仓库,安装Python 3.10及以上版本及必要的依赖包(如Diffusers、Transformers),并从Hugging Face下载模型权重文件。最后,通过运行提供的Python脚本启动本地服务。

- 使用Docker部署:为简化环境配置,可以使用社区提供的Docker镜像,快速构建一个包含所有必要依赖的隔离运行环境,从而避免复杂的本地安装过程。

Stable Video Diffusion的产品价格

Stable Video Diffusion本身是一个开源模型,用户可以免费下载模型权重并在符合要求的硬件上本地运行,无需支付软件授权费用。然而,如果通过第三方云平台(如Replicate、东方超算AI应用商店)的API接口调用该模型,则会产生计算资源费用,这些平台通常采用按量计费模式,例如每小时费用从几元到几十元人民币不等。

Stable Video Diffusion的适用人群

- AI技术爱好者与研究人员:希望深入探索视频生成模型原理、进行模型微调或相关学术研究的人员。

- 内容创作者与视觉艺术家:需要快速为静态图片添加动态效果,用于制作短视频、艺术创作或概念展示的创作者。

- 3D建模师与游戏开发者:寻求利用多视图生成能力辅助3D模型创建和场景构建的专业人士。

- 初创企业与营销团队:预算有限但需要高效生产营销视频、产品演示等内容的中小团队。

总而言之,Stable Video Diffusion是一款功能强大的开源视频生成模型,能够将静态图像或文本描述转化为短视频,支持高分辨率输出和多视图合成,为内容创作、3D建模和研究探索提供了灵活且经济的解决方案。