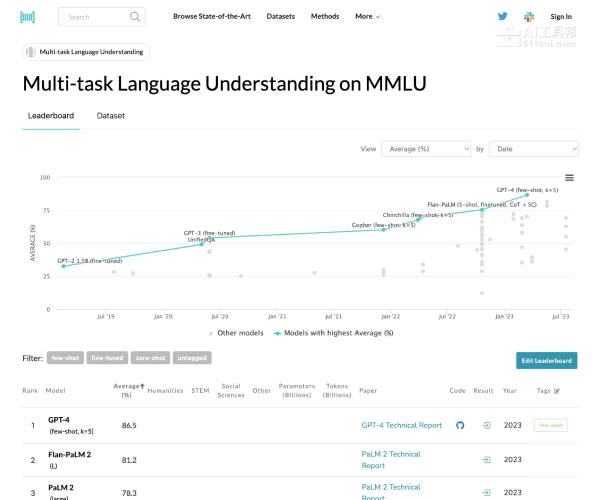

MMLU是什么

MMLU是加州大学伯克利分校研究人员于2020年9月推出的大模型测评基准,包含初等数学、计算机科学、法律、历史等57项学科任务,旨在评估大模型的跨领域知识覆盖和复杂问题解决能力。该基准通过统一提示词设计和标准化情境学习示例的HELM框架,解决了传统测评结果不一致的问题。

MMLU的主要功能

多学科知识评估:涵盖基础数学、美国历史、计算机科学、法律等57项学科任务,涉及人文、社会科学、自然科学三大知识领域,测试模型对世界理解能力和解决问题能力。

零样本和少样本测试:支持零样本和少样本两种测试模式,验证模型在未接触数据情况下的推理能力。零样本模式下模型仅依赖预训练知识,少样本模式下可参考少量示例完成任务。

标准化评估体系:采用选择题和开放式问答两种题型,其中选择题占比85%以上,重点考察知识记忆与基础推理。测评结果反映模型在数学推理、法律分析、历史事件理解等领域的表现差异。

MMLU的使用方法

- 下载基准数据集:官网提供MMLU数据集,包含多个任务的数据和参考答案。

- 准备模型架构:确保模型结构与基准测试要求一致,避免引入额外参数或组件。

- 执行推理测试:输入预设测试句子,生成模型输出并与参考答案对比,计算预设的指标(如准确率、F1分数等)。

MMLU的产品价格

MMLU是免费的开源基准测试工具,用户无需支付任何费用即可下载和使用数据集进行模型评估。

MMLU的适用人群

专业研究人员:用于测试和比较不同语言模型的性能。

研发工程师:帮助开发者改进模型结构和训练策略。

对自然语言处理感兴趣的技术人员:为语言模型提供统一的评估标准,促进技术进步。

总而言之,MMLU是一款用于评估大型语言模型在多学科知识和复杂任务中表现的重要基准测试工具,涵盖57个学科领域,通过零样本和少样本测试模式全面衡量模型的知识广度、推理能力和跨领域泛化能力。